J’ai lu pendant ces vacances le livre d’Emmanuelle Bermès, De l’écran à l’émotion : Quand le numérique devient patrimoine (Paris : Éd. de l’École nationale des chartes, 2024). J’y ai retrouvé bien des choses qui sous-tendent notre pratique, et des récits fondateurs qui se transmettent entre collègues, puisque Emmanuelle a longtemps travaillé dans le département de la Bibliothèque numérique de la BnF, puis comme adjointe au directeur des Services et Réseaux, en charge des affaires scientifiques et techniques. La notion de « patrimoine numérique » ne peut évidemment que me toucher, tout comme un plaidoyer pour une notion qui devrait aller de soi et qui peine pourtant à s’imposer. Mais il y a une idée qui sous-tend le propos du livre et sur laquelle je voudrais revenir parce qu’elle aborde un sujet important et qui m’est cher. Je la résume de la manière suivante :

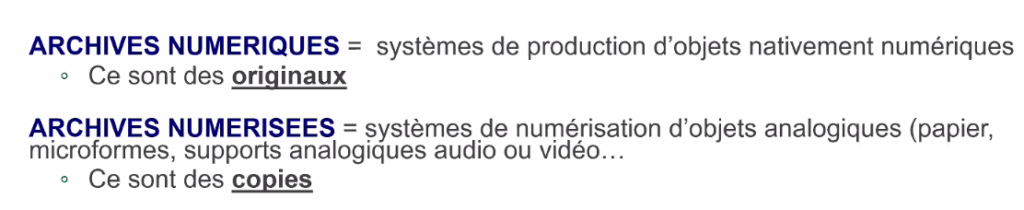

Le patrimoine numérique, c’est autant le numérisé que le nativement numérique, et les deux peuvent être abordés de la même façon.

On retrouve notamment cette idée page 179 :

Du point de vue de la définition du patrimoine numérique, cette démarche ou cette vision des choses a pour conséquence d’effacer la frontière qui pourrait exister, d’un point de vue herméneutique, entre le patrimoine numérisé, qui relève de la conversion au numérique d’un objet matériel physique, et le patrimoine nativement numérique, créé directement sous cette forme (…). Nous avions déjà assisté à ce phénomène de capillarité du côté des institutions, qui appliquaient les mêmes méthodes de conservation et de traitement à ces deux types d’objets (…).

Il est certain que, pour une lectrice qui consulte Gallica afin de lire de la presse du XXe siècle, le passage d’un fascicule numérisé à un fascicule produit directement par ordinateur est et doit rester transparent. Pour elle, le contenu n’a pas fondamentalement changé, et la « continuité des collections », maître-mot de nos collègues responsables de collection, doit s’imposer.

En revanche, pour la chercheuse qui étudie les archives nativement numériques d’un créateur ou pour les professionnels qui les collectent, les traitent et y donnent accès, la différence est fondamentale.

Je pilote, comme vous le savez peut-être, le groupe « Formats de données pour la préservation numérique » à la BnF. Depuis quelques mois, quand commence une réunion qui instruit un sujet spécifique, je tente de prendre l’habitude de poser la question suivante : le sujet est-il pertinent dans le cas de contenus numérisés ou de contenus nativement numériques ? Certes, il existe plusieurs cas où l’on peut parler des deux en même temps – pour la préservation du train d’octets (bit-level preservation) par exemple, la différence n’importe pas. Mais il en existe d’autres encore plus nombreux où elle importe immensément, et où tenter de traiter les deux en même temps nous amène à des quiproquos indémerdables.

Et ce, pour plusieurs raisons, dont la première a été rappelée par Thomas Van de Walle, directeur du numérique et de la conservation aux archives nationales lors de sa présentation de la préservation numériques aux AN lundi dernier.

C’est basique, mais ça ne semble pas une évidence pour tout le monde : entre l’objet original et une photocopie, même excellente, le nez de l’historien ne frétille pas de la même manière. Et pour cause : la meilleure numérisation d’un manuscrit médiéval composite tel que le cartulaire du Consulat de Limoges (désolé de prendre un exemple que j’ai bien connu…) ne pourra témoigner de l’histoire codicologique et de la matérialité de l’objet car elle ne pourra pas, par exemple, permettre d’analyser les fonds de cahier et donc l’histoire de l’assemblage progressif de cet objet. Dans le domaine du numérique, c’est pareil : les objets nativement numériques ont une profondeur informationnelle potentiellement infinie. De ce fait, les dérivés ou copies que vous ferez (par exemple, en transformant tous vos tableurs en fichiers images TIFF – ne riez pas, certains l’ont fait) appauvrissent forcément considérablement l’information présente dans l’original.

En effet, la numérisation de masse nécessite une standardisation qui réduit la complexité de l’objet original à une succession de captures photographiques de ses composantes. La numérisation à la BnF, c’est par nécessité carré-carré : les différents référentiels de numérisation s’assurent que tout ce qui sort des chaînes de production des prestataires soit exactement similaire : même résolution, même profil colorimétrique, mêmes métadonnées, pas de contenu qui dépasse. Du manuscrit au livre XXe siècle, de l’estampe du XVIIe siècle à la photographie XIXe, si les méthodes de numérisation changent, le produit final reste le même : une série d’images matricielles accompagnées si besoin d’une version textuelle obtenue par OCR1.

A l’inverse, reprenons l’exemple d’un fascicule de presse nativement numérique. Peut-être n’y voyez-vous qu’une succession d’images, mais en réalité il contient une combinaison d’éléments matriciels, vectoriels et textuels. De ce fait, on peut en multiplier les usages : l’imprimer à plus grande taille s’il est composé d’éléments textuels et vectoriels, en extraire le texte – avec difficulté, certes, mais tout de même –, voire les polices – ou au moins un sous-ensemble – . On peut parfois revenir à un état antérieur en identifiant des mises à jour incrémentales, on peut trouver des commentaires dans son code, on peut aussi y découvrir du texte hors des zones imprimables… Je ne parle même pas du fait que les producteurs de PDF ne sont pas pour la plupart des professionnels de l’édition et qu’ils produisent donc des fichiers plus ou moins cassés, voire détournent l’usage originel des mécanismes du format… Bref, un objet nativement numérique – et c’est particulièrement vrai de la plupart des documents au format PDF – est bien plus que ce que son impression permet d’en voir. On verra dans tous les billets pratiques dont je compte inonder ce blog ce que cela implique en termes d’actions concrètes et de compétences.

Pour vous en convaincre un peu plus, il suffit de voir ce que des spécialistes d’OSINT ou de criminalistique numérique sont capables d’extraire d’une simple photographie numérique originale. Or toute intervention sur des données, qui est conçue pour être extrêmement simple (vous altérez un fichier Word rien qu’en l’ouvrant et en le ré-enregistrant, même si vous n’avez fait aucune modification volontaire) est potentiellement destructive. D’où mon cri d’alarme dans ce précédent billet : leave the files alone – moins vous les touchez, mieux ils se porteront (mais pour ne faire que ce qui est nécessaire, il faut quand même savoir ce qu’on fait).

La BnF a plus de trente ans d’expérience de production et diffusion de contenus numérisés. Mais cette fois-ci, l’expérience a joué contre nous. Nous avons été naïfs de croire que, parce que nous savions traiter des documents numérisés, nous étions prêts à faire de même avec des contenus nativement numériques. Nous avons largement sous-estimé la diversité de ces derniers, et cette impréparation présomptueuse nous a conduits à faire des erreurs – dois-je vous rappeler notre mésaventure du JPEG bleu, qui n’était qu’un bête JPEG dans un modèle couleur CMJN ? Faute de savoir identifier ses caractéristiques et d’agir en conséquence, nous le restituons mal. Bref, vous n’êtes pas prêt·e·s pour le nativement numérique. C’est pas grave, nous non plus on ne l’était pas (et on est encore loin de maîtriser le sujet), tout cela s’apprend, mais mieux vaut mesurer avant l’effort qu’il faudra fournir.

Si je schématise : pour faire de la numérisation, il faut savoir beaucoup sur deux ou trois structures de formats ; pour collecter du nativement numérique, il faut savoir peu sur de très nombreuses structures de formats. Eh oui, c’est malheureux mais c’est comme ça : il va falloir apprendre des choses sur de nombreux formats de fichiers. Certains vont trouver ça barbant, moi je trouve ça bien plus excitant. Les goûts et les couleurs, tout ça.

Bref, je ne pense pas qu’avec Emmanuelle nous soyons véritablement en désaccord sur ce point – nous ne parlons pas au même niveau de réalité. Mais il me semble que de traiter de manière égale ces deux réalités occulte la complexité des collections nativement numériques et le besoin de professionnels avec une très solide compétence numérique, qui passe par la maîtrise des outils en ligne de commande, un peu de programmation et une connaissance des subtilités de l’encodage de l’information numérique – tout à fait comparable d’ailleurs aux sciences auxiliaires de l’histoire, qui sont elles aussi très « techniques ». Et force est de constater que dans les filières bibliothéconomiques classiques, cet équipement théorique et pratique n’est pas transmis2.

Bon, j’ai l’impression que le blog a à peine quelques mois et que j’écris déjà plusieurs fois le même billet. Pour changer, le prochain sera (peut-être) dédié à notre récent travail sur un fonds d’archives numériques et à notre changement d’approche par rapport aux précédentes expérimentations. Il y aura de l’identification d’informations personnelles avec la commande Unix pdfgrep, de la détection de doublons avec DROID, ça va être chouette.

1On m’objectera peut-être qu’il existe des méthodes de numérisation avancées – numérisation 3D, numérisation multi-spectrale, etc. mais à la BnF ces approches sont encore expérimentales et/ou limitées à un très petit nombre de documents.

2Le master Technologies numériques appliquées à l’histoire que coordonne comme par hasard Emmanuelle à l’École des chartes est actuellement pour moi l’exception qui confirme la règle.

Laisser un commentaire